|

Institut für Informatik |

ProjektgruppeSMART ACT - Ungewissheitsbehandlung in der Automatisierungstechnik |

| Projektleitung | Prof. Dr.-Ing. Werner Brockmann, Jan H. Schoenke, M.Sc., Jonas Schneider, M.Sc. |

| Projektidee |

Automatisierungssysteme werden immer komplexer und zunehmend in einer natürlichen Umgebung eingesetzt oder interagieren mit Menschen. Dadurch steigen die Anforderungen an einen absolut sicheren Betrieb. Das gilt zum Beispiel sowohl für die Automatisierung von Fertigungsstrass;en oder Verpackungsmaschinen als auch besonders für Fahrerassistenzsysteme in Kraftfahrzeugen oder autonome mobile Roboter. Solche Systeme sind essentiell von zuverlässigen Sensorsignalen abhängig, denn Störungen eines Sensors führen zu einer unsicheren Informationslage, die zu einem anormalen, kritischen Systemverhalten führen kann. Das gleiche gilt auch für Interaktionsfehler, die bei der Umsetzung von intendierten Aktionen auftreten können. Kritisch ist auch, wenn im laufenden Betrieb gelernt wird, um bspw. das Systemverhalten zur Laufzeit an sich ändernde Betriebsbedingungen anzupassen. Denn dadurch entstehen neue Typen von Unsicherheiten.

Trotz Anomalien und Unsicherheiten muss das Automatisierungssystem jederzeit sicher und zuverlässig arbeiten, damit dem System oder der Umgebung, in dem es eingesetzt ist, kein Schaden zugefügt wird. Daher ist unser Ansatz durch konstruktive Mass;nahmen das Automatisierungssystem in die Lage zu versetzen, Anomalien und Unsicherheiten selbständig zu erkennen und im laufenden Betrieb abhängig vom Grad der Abweichung vom Normalfall Gegenmass;nahmen zu ergreifen. Dazu wurde das Trust Management-Framework entwickelt. Dabei geben sogenannte Trust Signale als Attribute den Grad der Anomalie potentiell für alle Informationsgröss;en an. Diese Trust Signale werden dann entweder auf Architekturebene genutzt, um die Interaktion von Systemmodulen zu steuern oder direkt in den Algorithmen verarbeitet, um einen optimalen Kompromiss aus Sicherheit und Performanz zu erzielen. Im Rahmen dieser Projektgruppe sollen anhand einer konkreten Anwendung das Trust Management-Framework einmal komplett von der Verarbeitung der Sensorsignale bis zur Rückwirkung auf die Anwendung, also bis zur konkreten Ansteuerung von Aktoren, umgesetzt werden. Dabei werden die Trust Management-Methoden auch auf die Anpassung an Anomalien durch Selbstoptimierung mittels Online-Lernen angewendet, um zur Laufzeit gezielt angemessene Gegenmass;nahmen zu bestimmen. Im Idealfall werden so sowohl die Performanz und Zuverlässigkeit des Systems erhöht als auch der Entwurfsvorgang vereinfacht. |

| Anwendung |

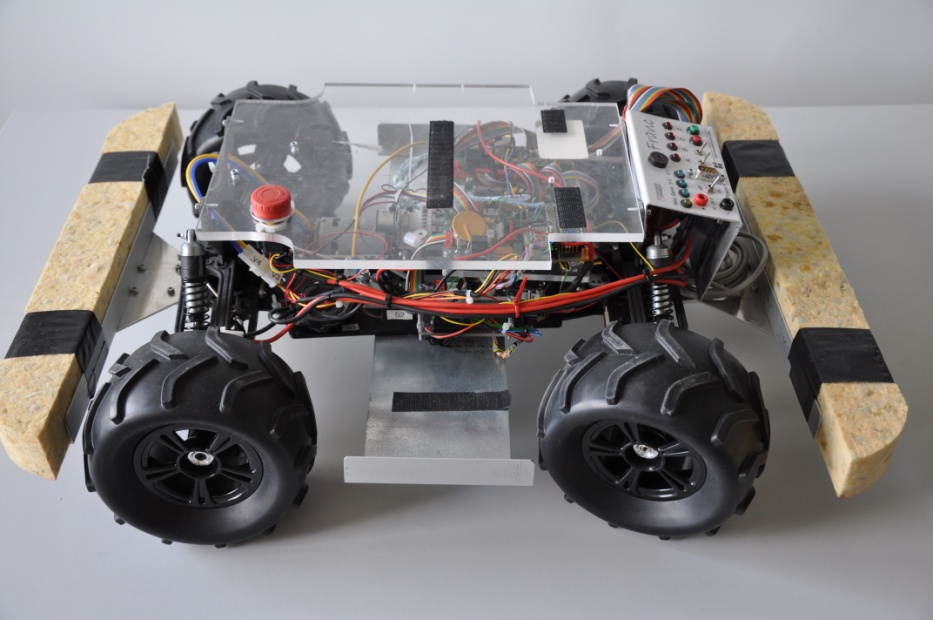

Ein zentraler Bestandteil der Projektgruppe ist die Umsetzung in eine reale Anwendung. Damit diese praktische Umsetzung und der Betrieb in einer Laborumgebung möglich sind, dient als exemplarisches Automatisierungssystem ein autonomer mobiler Roboter, der trotz Anomalien und Unsicherheiten ein möglichst optimales Verhalten zeigen soll. D.h. trotz einer unsicheren Umgebungswahrnehmung, potentiell durchdrehender Räder etc. soll er mit hoher Geschwindigkeit oder in kritischen Fahrsituationen manövrieren können, ohne Sicherheitsgarantien zu verletzen.

Dazu wird eine modulare, hierarchische Software-Architektur verwendet, bei der die funktionstragenden Module um spezielle Module ergänzt werden, die die Überwachung des Systemzustands und die explizite Modellierung von Unsicherheiten vornehmen. Ein wichtiger Punkt wird die algorithmische Erweiterung zur unsicherheitsabhängigen Modifikation des Systemverhaltens sein. Darüber hinaus soll Lernen eingesetzt werden, um einerseits Referenzverhalten und Interaktionsmuster zu lernen und andererseits das Systemverhalten zur Laufzeit zu optimieren und flexibel an die Unsicherheiten anzupassen. |

| Teilaufgaben |

Einarbeitungsphase an einem stark vereinfachten simulierten Beispiel in

|

| Ablauf und Workload |

Die Projektgruppe läuft über einen Zeitraum von zwei Semestern und der Workload ist mit 24 Leistungspunkten veranschlagt. Dies entspricht einem Gesamtworkload von ca. 720 Stunden, verteilt auf 52 Wochen inklusive Vorlesungsfreier Zeit ergeben sich damit 12 Wochenstunden für die Dauer der Projektgruppe. Zur besseren Koordination wird es 6 SWS Präsenzzeit geben, die restliche Zeiteinteilung erfolgt frei. In regelmäss;igen Abständen werden Meetings und Vorträge zum aktuellen Stand des Projektes stattfinden, in denen aktuelle Ergebnisse und noch offene Problemstellungen präsentiert und diskutiert werden. Am Ende des Projekts wird eine schriftliche Ausarbeitung abgegeben und die Ergebnisse werden in einer Abschlusspräsentation präsentiert. Startworkshop: Mittwoch, 15. April 2015, 10.15 Uhr, Raum 31/339 |